В мире информации и большого объема текстовых данных поиск похожих документов становится все более актуальной задачей. Одним из эффективных методов решения этой задачи является алгоритм LSA (Латентно-семантический анализ).

LSA, также известный как алгоритм редуцирования размерности, основывается на предположении, что слова используются в похожих контекстах и могут быть синонимами друг друга. Алгоритм LSA анализирует матрицу терминов-документов и использует методы линейной алгебры для снижения размерности пространства. Таким образом, LSA может определить схожесть документов, даже если в них встречаются разные слова.

Алгоритм LSA часто применяется в задачах информационного поиска, анализе текстов и SEO (Search Engine Optimization). Он позволяет улучшить качество поиска и ранжирования страниц в поисковых системах, учитывая не только точное совпадение ключевых слов, но и их семантическую близость.

Алгоритм LSA для поиска похожих документов

Применение алгоритма LSA для поиска похожих документов основано на представлении текстов в виде матрицы термы-документы. В этой матрице каждому документу сопоставляется вектор, в котором каждая компонента отражает важность определенного терма в данном документе. Затем матрица сингулярного разложения (SVD) применяется к этой матрице, чтобы найти наиболее существенные семантические компоненты.

После применения алгоритма LSA, для поиска похожих документов происходит сравнение векторов документов, основанное на их семантической близости. Документы, которые имеют близкие векторы, считаются похожими. Это позволяет улучшить качество поиска, поскольку позволяет учесть не только точное совпадение ключевых слов, но и семантическую связь между ними.

Алгоритм LSA широко применяется в информационном поиске, рекомендательных системах, классификации текстов и других задачах, где требуется анализ текстового контента. Он помогает повысить точность и эффективность поиска и классификации, позволяя учитывать семантическую близость между документами и словами.

Принципы работы алгоритма LSA

Работа алгоритма LSA начинается с создания матрицы термы-документы, где каждый столбец соответствует документу, а каждая строка — терму. Затем на этой матрице применяется сингулярное разложение (SVD), которое позволяет сжать пространство до меньшей размерности.

В результате применения SVD получается матрица, где строки соответствуют документам, а столбцы — семантическим особенностям. Каждый элемент этой матрицы представляет собой вклад семантической особенности в документ. Таким образом, документ представляется в виде вектора, а семантическая близость между документами может быть вычислена с помощью скалярного произведения их векторов.

После сжатия пространства и выделения семантических особенностей, алгоритм LSA позволяет выполнять поиск похожих документов, основываясь на их векторных представлениях. Он позволяет определить, насколько два документа близки по семантическому содержанию, что может быть полезным для SEO-специалистов при оптимизации контента и распределении внутренних ссылок.

Снижение размерности пространства

Снижение размерности основывается на простом принципе: вместо работы с исходными признаками документов в LSA используются линейные комбинации этих признаков, которые позволяют представить документы в более компактном виде. Таким образом, происходит сокращение размерности пространства, что позволяет сэкономить вычислительные ресурсы и ускорить процесс поиска.

Преимущества снижения размерности пространства в алгоритме LSA:

- Улучшение временной эффективности: Сокращение размерности пространства позволяет снизить количество вычислений, что существенно сокращает время выполнения алгоритма и позволяет обрабатывать большие объемы данных.

- Уменьшение объема хранения данных: Благодаря снижению размерности пространства требуется меньше памяти для хранения информации о документах и признаках, что особенно важно при работе с большим количеством документов или приложениях с ограниченными ресурсами.

- Улучшение точности алгоритма: Сокращение размерности позволяет избавиться от шума или противоречивых данных, что приводит к повышению качества поиска похожих документов и более точным результатам.

В итоге, снижение размерности пространства является важным шагом в алгоритме LSA, который значительно повышает эффективность и точность поиска похожих документов. Этот метод позволяет сэкономить вычислительные ресурсы, ускорить алгоритм и улучшить его результаты.

Создание матрицы терминов и документов

Процесс создания матрицы начинается с предварительной обработки текстовых документов. Тексты приводятся к нижнему регистру и разбиваются на отдельные термины, которые называются токенами. Также может быть применена фильтрация стоп-слов, то есть удаление слов, не несущих содержательной нагрузки, таких как предлоги, союзы и т. д.

После этого происходит подсчет количества вхождений каждого термина в каждый документ. Эта информация заполняет ячейки матрицы. В некоторых случаях может использоваться весование терминов, чтобы учесть их важность в документе. Это может быть, например, частота встречаемости термина или встречаемость термина в других документах коллекции.

Полученная матрица представляет собой числовую таблицу, где каждый элемент описывает связь между термином и документом. Она является основой для дальнейшей работы алгоритма LSA, включая снижение размерности и выявление семантической связности между документами.

Расчет сингулярного разложения

Сингулярное разложение матрицы позволяет представить исходные данные в виде произведения трех матриц: матрицы левых сингулярных векторов, матрицы сингулярных чисел и матрицы правых сингулярных векторов.

Матрица левых сингулярных векторов содержит информацию о сходстве слов между собой. Матрица сингулярных чисел отражает важность каждого из сингулярных векторов. Матрица правых сингулярных векторов показывает сходство каждого документа с одним из понятий, выраженных в левых сингулярных векторах.

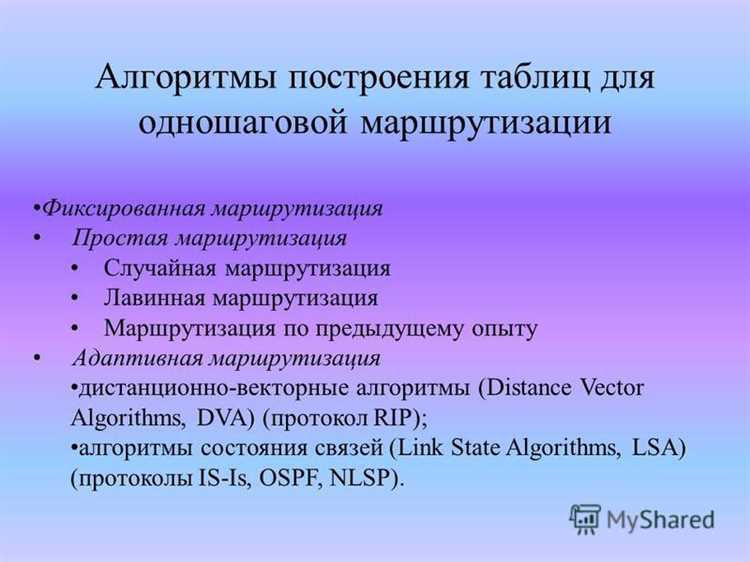

Сингулярное разложение имеет множество практических применений, включая поиск похожих документов, построение рекомендательных систем, анализ текстов и многие другие. Оно является основой алгоритма LSA (Latent Semantic Analysis), который используется в поисковых системах для определения семантической близости между документами.